Introduction

Fonctionnement d’un modèle de génération d’images

Les modèles d’IA génératives sont constitués via un entraînement sur de gigantesques bases de données d’images, très souvent provenant d’internet (webscraping). Dans le cas des IA génératives d’images, il s’agit d’images classées et étiquetées qui sont fournies aux algorithmes afin qu’ils s’entraînent à en reconnaître les caractéristiques et ensuite à produire des visuels répondant à toutes les demandes (prompts) possibles des utilisateurs.

Il est difficile de remonter aux sources des images qui ont permis d’entraîner les modèles d’IA. Étaient-elles dans le domaine public ? Leurs auteurs avaient-ils donné leur accord pour cette exploitation ?

D’autant plus que certaines entreprises ont mis en place des stratégies très élaborées pour les collecter à bas coût. Ce qui ne facilite pas la traçabilité.

Quel outil utiliser pour générer des images à titre professionnel ?

Si vous travaillez pour le Groupe BPCE

Adobe Firefly est l’outil de génération d’images retenu par le groupe pour les experts ayant pris connaissance des risques des usages non conformes ou d’outils non encadrés par le groupe. L’utilisation des autres services existant ou à venir n’est pas autorisée.

✅ Adobe Firefly

Pour un usage commercial : “Les fonctionnalités de Firefly qui ne sont plus en version bêta peuvent désormais être utilisées à des fins commerciales. D’autres, qui sont encore en version bêta, ne sont toujours pas destinées à un usage commercial. Par conséquent, vous devez bien vérifier le statut des différentes fonctionnalités de Firefly dans chaque application. “ … “Firefly est entraîné sur des centaines de millions d’images haute résolution d’Adobe Stock, le contenu sous licence libre et celui tombé dans le domaine public. Il est conçu pour créer du contenu utilisable en toute sécurité à des fins commerciales.”

Adobe positionne son IA générative comme un modèle plus sûr pour des usages commerciaux car il est entraîné sur une banque d’images lui appartenant ; mais qui peut être moins performant sur certains types d’images en raison d’un corpus d’entraînement plus restreint que d’autre IA génératives.

Attention : Adobe ne garantit les utilisateurs contre une action en contrefaçon sur les résultats obtenus par son système d’IA uniquement dans la mesure où l’utilisateur a utilisé le résultat tel qu’obtenu, sans faire aucune modification ou ajout et sans avoir lui-même uploadé une image ou vidéo dans son prompt ne provenant pas de la base d’Adobe Stock.

Pour utiliser Adobe Firefly, vous vous engagez donc à respecter les bonnes pratiques décrites dans ce guide.

Autres outils d'IA génératives d'images

L'utilisation de tout autre outil de génération d’images est actuellement proscrit dans le Groupe BPCE.

❌ Stability.AI

Stability.AI est une bonne illustration de ces stratégies et des problèmes qu’il peuvent créer.

Stability.ai est une entreprise privée qui vend notamment des services et des API de génération d’images. Cette organisation contribue au développement d’un modèle de génération d’images « open source » très célèbre nommé Stable Diffusion et sur lequel s’appuient certaines de ses offres payantes. En 2022 la base de données sur laquelle le modèle avait été entrainé comptait selon une estimation 2.3 milliards d’images classées et étiquetées.

Cette base s’appelle LAION. Il s’agit un projet a but non lucratif et « open source » qui a pu constituer sa base grâce à une autre organisation à but non lucratif elle aussi, appelée Common Crawl, dont la mission est de parcourir et d’archiver le contenu de milliard de pages Web. Parmi ces pages web, on trouve notamment celles de sites tels que Pinterest, des blogs WordPress, Flickr, Tumblr, Getty-Images, Istockphoto, etc.

Il est donc très probable que la plupart des images sur lesquelles Stable Diffusion a été entrainées et qui permettent à l’entreprise Stability.ai de vendre ses services soient soumises au droit d’auteur.

Pour autant l’entreprise ne les a pas payés, car elle exploite des modèles open source qui ont été fabriqués avec le support de données fournies gratuitement par des organisations à but non lucratif.

Il existe donc un risque de violation des droits d’auteur, car les images générées peuvent ressembler de manière significative à des œuvres protégées par le droit d’auteur. De plus, il peut être difficile de prouver l’originalité des images créées, ce qui complique la protection des droits d’auteur en cas de litige. L’attribution de la paternité des œuvres peut également être floue, ce qui rend difficile la reconnaissance des créateurs. Enfin, la réutilisation non contrôlée des images générées par Stability.AI peut compromettre la capacité des créateurs à protéger et à valoriser leur propriété intellectuelle.

Cette façon de développer certains modèles d’IA est critiqué et donne lieu à plusieurs procès aux Etats-Unis (actuellement en cours) entre des ayants droits et des entreprises qui fournissent des services de génération d’images.

❌ Midjourney

Midjourney concède aux utilisateurs la propriété de tout ce qui est produit sur sa plateforme avec quelques contraintes, notamment :

Si l’utilisateur est ou travaille pour une entreprise générant plus de 1.000.000 $ de CA, il doit souscrire un compte “Pro” ou « Mega » payants.

L’utilisation de Midjourney concède aux utilisateurs de la plateforme le droit d’utiliser tout ce qui est fait par d’autres utilisateurs dedans… En conséquence, d’autres utilisateurs peuvent avoir accès de manière indirecte aux résultats produits grâce à vos prompts et ils seront potentiellement réincorporé dans d’autres résultats.

Selon les conditions d’utilisation de MidJourney, les utilisateurs détiennent toutes les oeuvres qu’il crée avec le service. Toutefois, l’entreprise exige une licence de copyright des utilisateurs pour reproduire le contenu créé avec le service. Il s’agit d’une précaution nécessaire pour héberger les images des utilisateurs.

En tout état de cause, le service est fourni sans aucune garantie de non contrefaçon à l’égard des résultats obtenus par l’utilisateur.

A propos du droit d’auteur

La protection des auteurs en France

- En droit français, la protection d’une œuvre est assurée par le droit d’auteur dès sa création sans nécessiter d’enregistrement, pourvu que l’œuvre soit originale c’est-à-dire qu’elle reflète la personnalité de son auteur. Cette protection offre à l’auteur des droits exclusifs sur l’utilisation de son œuvre, notamment en termes de reproduction, de représentation et d’adaptation, pour une durée qui s’étend jusqu’à 70 ans après sa mort. Après quoi l’œuvre entre dans le domaine public. Cependant, le droit moral de l’auteur, qui comprend le droit au respect de son nom et à l’intégrité de son œuvre, continue de s’appliquer car il est perpétuel, inaliénable et imprescriptible.

- L’exception de courte citation (article L.122-5 3° du CPI) selon laquelle « lorsque l’œuvre a été divulguée, l’auteur ne peut interdire, sous réserve que soient indiqués clairement le nom de l’auteur et la source, les analyses et courtes citations justifiées par le caractère critique, polémique, pédagogique, scientifique ou d’information de l’œuvre à laquelle elles sont incorporées » n’est pas reconnue dans le domaine des œuvres graphiques et plastiques si l’œuvre concernée est reproduite dans son intégralité, quel que soit son format.. C’est-à-dire que le fait de montrer une œuvre soumise au droit d’auteur (par exemple un mobilier signé d’un célèbre designer) dans une création est proscrit si l’œuvre concernée est reproduite dans son intégralité, quel que soit son format.

- « L’appropriation » ou « Fair use » en droit américain d’une œuvre pour en changer le style ou le médium n’est pas reconnue par les tribunaux français. En droit français, la création d’une œuvre composite ou dérivée (nouvelle œuvre incorporant une œuvre première) par exemple en utilisant une IA générative, va supposer d’avoir obtenu l’autorisation de l’auteur de l’œuvre d’origine.

- La règle des 70% de similarité est une légende urbaine ! Il existe un mythe rependu chez les professionnels du design qu’au-delà d’un certain pourcentage de différences avec l’œuvre d’origine il n’est pas possible d’être attaqué pour contrefaçon. En réalité l’estimation de la similarité est laissée à l’évaluation subjective du juge.

- En règle générale, le fait de profiter du travail d’autrui en reprenant ou en imitant le style d’un auteur ou l’œuvre d’un auteur peut engager la responsabilité du « créateur » au titre du parasitisme.

Cependant, inspiration n’est pas contrefaçon.

- Les idées et les concepts ne sont pas protégés par le droit d’auteur. Pour qu’une œuvre soit protégée par le droit d’auteur, elle doit être formalisée et originale.

- La « Rencontre fortuite » est opposable si l’accusé de contrefaçon prouve qu’il n’a pas pu matériellement avoir accès à l’œuvre concernée. Attention, cela peut être compliqué à démontrer en pratique.

- Il est possible que des œuvres se ressemblent dans la mesure où elles sont basées sur des « Réminiscences issues de sources d’inspirations communes ». C’est le cas pour des créations s’inspirant d’un même « fond commun » (Folklore, symboles, mythologie…)

- Enfin, « l’exception de parodie » s’applique lorsqu’il y a dans la création une recherche d’humour et plus rarement, une volonté de réaliser un hommage, ou un critique. Cependant, elle doit être réalisée sans intention de nuire et ne pas présenter de risque de confusion avec l’œuvre originale. Attention aux marques pour lesquelles le droit de parodie de n’applique pas. Sauf si on se place dans le cadre du droit à la liberté d’expression…

Recommandations

1. Les noms d’auteurs ou d’œuvres

N’invoquez pas dans vos prompts des noms d’auteurs ou d’œuvres qui ne sont pas dans le domaine public (pour rappel, une œuvre originale est protégée par le droit d’auteur pendant 70 ans à compter de la mort de l’auteur). Ou assurez-vous d’avoir l’autorisation de l’auteur de l’œuvre d’origine.

✅ DO :

Exemple → Prompt : Portrait photography business woman looking like Sherlock Holmes

❌ DON’T :

Exemple → Prompt : Realistic Photography bank advisor looking like Harry Pottrer

2. Les personnes

Ne citez pas des personnes célèbre vivantes dans vos prompts. N’essayez pas non plus de représenter des individus qui n’ont pas donné leur accord en les décrivant précisément. En tout état de cause, lorsqu’une ou plusieurs personnes physiques figure(nt) dans le contenu généré par une IA, assurez-vous d’avoir une autorisation de droit à l’image de la/des personne(s) concernée(s) (sauf si ces personnes sont 100% virtuelles) pour exploiter les images générées.

✅ DO :

Exemple → Prompt : Financial Advisor Portrait Picture

❌ DON’T :

Exemple → Prompt : Realistic Photography business woman looking like Nicole Kidman, glamorous look, long blond hair

3. Les marques

Ne citez pas de marques de tiers dans vos prompts dont vous n’êtes pas titulaire ou pour lesquelles vous n’avez pas de licence d’exploitation.

✅ DO :

Exemple → Prompt : Paris based banking agency

❌ DON’T :

Exemple → Prompt : London based banking agency near Dior shop

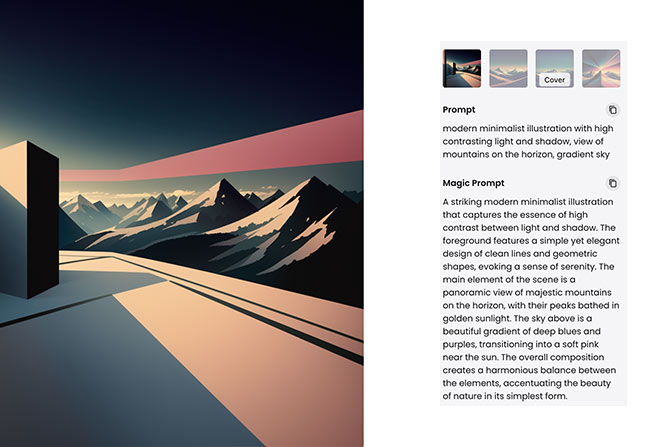

4. L'utilisation de fichiers en référence dans les prompts

Sur les outils d’IA générative qui le permettent, n’injectez pas dans votre prompt une image ou tout autre support sur lequel vous n’avez pas la certitude de disposer des droits autorisant ce type d’usage.

✅ DO :

Exemple → Prompt : modern minimalist illustration with high contrasting light and shadow, view of mountains on the horizon, gradient sky

❌ DON’T :

Exemple → Prompt : https://www.partfaliaz.com/fr/wp-content/uploads/2016/03/thomas-danthony-F.jpg modern minimalist illustration with high contrasting light and shadow, view of mountains on the horizon

5. Bonnes pratiques pour l'utilisation commerciale des images produites par l'IA

👉 Assurez-vous qu’une forme très proche de l’image générée par IA que vous voulez exploiter, n’existe pas déjà, via par exemple une recherche d’images similaires dans Google.

👉 Retouchez les productions des IA génératives pour y apporter une touche personnelle et corrigez les hallucinations souvent présentes dans les images générées par l’IA.

👉 Sauvegardez vos prompts et assets orignaux afin de pouvoir prouver le cas échéant que vous n’avez pas cherché à copier ou à parasiter une œuvre ou un auteur titulaire de droits.

Votre engagement

Prét(e) à utiliser l’IA générative d’images dans vos projets au sein du Groupe BPCE ? Validez ce formulaire pour confirmer que vous avez bien compris et accepté ces pratiques.

IA responsable

Le groupe BPCE a défini un cadre pour une utilisation responsable de la donnée, ces règles sont rappelées dans un module de e-learning à destination de tous les collaborateurs :

DATA – L’utilisation responsable de la donnée et de l’intelligence artificielle (code Click&Learn NL000835) .

Il convient de s’y référer pour :

- avoir une meilleure connaissance des usages avancés de la data,

- maîtriser les nouvelles responsabilités liées à ces usages et le cadre défini par le Groupe pour une utilisation responsable des données et des solutions d’intelligence artificielle.

Ethique des algorithmes pour les designers d'applications basées sur l'IA

Le droit et l'éthique des IA évolue !

Ces recommandations représentent des tendances actuelles dans le domaine du droit et de l'éthique des IA. Elles peuvent continuer à évoluer et pourront donner lieu à des adaptation dans le droit local de chaque pays.

1. Risques de biais et opacité

Les modèles d’IA induisent par leur nature un certain nombre de risques. Il faut les connaitre pour les éviter lorsque l’on exploite des outils ou que l’on conçoit des services qui reposent sur l’IA. Nous donnons des exemples ici de quelques-uns de ces risques dans des usages fréquents de l’IA et leur origine probable.

Exemple 1 : l’IA pour la reconnaissance faciale

Problème : Sur les premières versions de ce type d’outils, des taux d’erreurs plus élevés ont été constatés avec certaines origines ethniques que pour d’autres.

Origine : Ces modèles étaient basés sur des corpus d’images de références déséquilibrés, incomplets, ou non représentatif. Ils fonctionnent donc moins bien avec certaines personnes dont l’ethnie n’était pas représentée dans les données d’entraînement.

Exemple 2 : L’IA pour le recrutement

Problème : Une IA entrainée pour sélectionner les meilleurs profils pour des postes techniques dans une grande entreprise tech finit par ne sélectionner que des profils masculins.

Origine : Cette entreprise s’est basée sur son propre historique de recrutements pour entraîner son modèle. Elle avait tendance à recruter plus d’hommes que de femmes pour ce type de postes. Les modèles d’IA ont naturellement tendance à accentuer des biais existants dans les données fournies pour leur entrainement.

Exemple 3 : L’IA dans la Justice

Problème : Une équipe de chercheur en IA (assez peu sérieuse) annonce pouvoir évaluer la probabilité qu’une personne soit un délinquant à partir d’une photo de son visage.

Origine : Au-delà de la pertinence sociale très discutable de ce projet, il existait des biais implicites dans les données d’entraînement. Le modèle avait été entraîné avec des photographies prises en prison pour les délinquants et d’autres types de photographies pour les autres personnes. Des éléments liés aux décors, aux vêtements ou à l’expression des sujets ont fortement influencé le modèle.

2. Les “fiches modèles” (model cards) pour une communication plus transparente sur les biais et risques potentiels des produits basés sur l’IA

Il s’agit d’une bonne pratique mise en place par un certain nombre d’entreprises avancées dans le domaine de la création de services basés sur l’IA. Elles ont pour but d’encourager la responsabilité et la transparence. Elles aident à prévoir les biais, les inégalités et les défauts potentiels d’un modèle avant qu’il ne soit déployé dans un contexte réel et informent l’utilisateur du service afin qu’il ait une meilleure compréhension de son fonctionnement et de ses limites.

Ces fiches contiennent :

- L’objectif du modèle : Une description de ce que le modèle est censé faire, le problème qu’il résout, et le contexte dans lequel il est destiné à être utilisé.

- Ses performances : Des détails sur les performances du modèle, tant quantitatives que qualitatives.

- La liste des données d’entraînement : Des informations sur les données utilisées pour entraîner le modèle, y compris leur source, leur volume et les étapes de prétraitement qui ont été appliquées.

- La liste des biais connus : Une présentation des biais potentiels dans les données d’entraînement et comment ils peuvent affecter les performances du modèle.

- Les limites d’utilisation : Des avertissements sur les situations où le modèle pourrait ne pas fonctionner correctement, ou quand son utilisation pourrait être éthiquement ou légalement problématique.

- La méthodologie d’entraînement : Des détails sur les techniques d’apprentissage automatique utilisées pour entraîner le modèle.

3. Ce que dit la loi

L’IA Act

En Europe, l’IA Act définit les grands principes qui pourront aboutir sur des réglementations qui encadreront les produits et services exploitant l’intelligence artificielle. Son ambition est de rendre les SIA (Systèmes d’IA) :

- sûrs,

- transparents

- traçables,

- non discriminatoires,

- respectueux de l’environnement.

L’IA Act classe les Systèmes d’IA (SIA) en 4 niveaux de risques impliquant chacun des règles et des contraintes.

❌ Les SIA à Risque inacceptablesont interdits

Il s’agit de SIA qui auraient pour but de manipuler des personnes vulnérables en raison de leur âges, handicap, situation sociale ou économique, produire un score social, de la reconnaissance biométrique à distance et en temps réel dans les espaces publics*

(*) Sauf à des fins de maintien de l’ordre, de recherche ciblée de victimes, de prévention d’une menace terroriste, de localisation ou l’identification d’une personne soupçonnée d’avoir commis l’un des crimes mentionnés dans le règlement et sous réserve d’une autorisation judiciaire préalable.

⚠️ Les SIA à haut risque sont contrôlées

Ce sont par exemple des SIA dans les infrastructures dites « critiques » telles que l’énergie, les transports, l’éducation ou la formation professionnelle, les dispositifs médicaux, l’emploi et les ressources humaines, les services publics et privés essentiels (ex : l’évaluation du risque de crédit pour obtenir un prêt), les SIA utilisés dans les domaines de l’application de la loi, du contrôle des frontières, de l’administration de la justice et des processus démocratiques, etc.

Principales obligations :

- Effectuer une analyse d’impact du SIA sur les droits fondamentaux, applicable également aux secteurs de l’assurance et de la banque,

- Les citoyens ont le droit de déposer des plaintes contre ces SIA et de recevoir des explications sur les décisions prises sur la base de SIA à haut risque qui ont une incidence sur leurs droits.

Les SIA à haut risque sont référencés dans une base de données européenne

ℹ️ Les SIA à Risque limité sont soumises à certaines obligations

Les chatbots, les dispositifs de reconnaissance des émotions, les outils de géneration de texte ou d’image, etc. doivent respecter des des exigences minimales à respecter pour permettre aux utilisateurs de prendre des décisions « éclairées ».

Principales obligations :

- Transparence : Informer l’utilisateur du fait qu’il interagit avec une IA

- Alerter sur les risques des modèles (Hallucinations, deepFake…) et mettre en place des dispositifs de contrôle.

- Publier la liste des données protégées par le droit d’auteur utilisées pour l’entrainement de son modèle.

✅ Les SIA à risque faible ou minimal comme des filtres anti-spam ne sont pas soumises à des obligations.

Les entreprises peuvent néanmoins s’engager à suivre des codes de conduite supplémentaires.